Retroscena

Presto sarà possibile dimostrare l'autenticità delle foto?

di David Lee

Se un'immagine, un testo o un video è stato creato utilizzando l'intelligenza artificiale (IA), dovrebbe essere indicato come tale. Ma non è così semplice. L'esempio di Instagram è il più recente, ma finora anche tutti gli altri tentativi sono falliti miseramente.

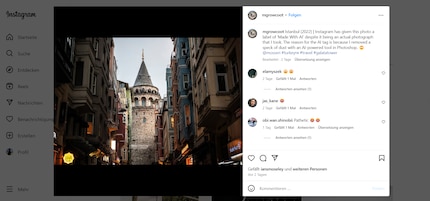

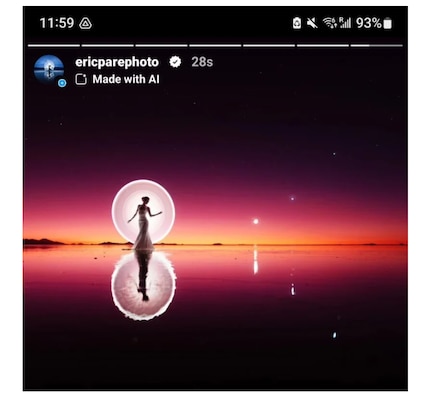

La trasparenza è importante quando si tratta di contenuti generati dall'intelligenza artificiale. Meta, l'azienda dietro Facebook e Instagram, vuole etichettare le immagini generate dall'intelligenza artificiale come tali, in modo che nessuno venga ingannato. Dal maggio 2024, alcune foto su Instagram sono state contrassegnate con «Made with AI». Almeno negli Stati Uniti. Io non ho ancora visto nessun contrassegno di questo tipo finora. Non sembra sia ancora attivo in Europa.

L'idea è lodevole. C'è solo un piccolo problema: non funziona. Secondo vari report, Instagram contrassegna anche immagini reali che non sono state assolutamente generate con uno strumento di intelligenza artificiale. Questo infastidisce i fotografi e le fotografe interessate.

Il motivo non è ancora del tutto chiaro. Meta rivela poco su come vengano contrassegnate le immagini. Una cosa è chiara però: l'azienda si affida a filigrane inserite nei metadati dagli stessi strumenti di IA. Tuttavia, questo può essere facilmente aggirato, ad esempio caricando uno screenshot dell'immagine.

Anche Photoshop utilizza tecniche di intelligenza artificiale, ad esempio per il ritocco o la riduzione del disturbo. Adobe fa parte dell'organizzazione C2PA, che si dedica alla trasparenza dei contenuti creativi. Sospetto che Photoshop dichiari nei metadati quando un'immagine è stata elaborata con l'aiuto dell'IA per motivi di trasparenza.

Ma questo non rende una foto scattata in modo convenzionale «Made with AI». C'è una bella differenza tra un'immagine alla quale viene ritoccata una macchia che disturba e un'immagine creata da zero con Midjourney, Dall-E o Stable Diffusion.

Le Content Credentials, un tipo di filigrana digitale crittografata, vengono utilizzate per dimostrare l'autenticità delle immagini e rendere trasparenti le singole fasi di elaborazione, incluse quelle dell'intelligenza artificiale. L'obiettivo è garantire una documentazione completa del processo di creazione.

Con questi metadati criptati, chi lavora nell'ambito creativo può dimostrare ciò che ha creato. Tuttavia, non è possibile il contrario. Infatti, non si possono usare le filigrane per dimostrare che un'immagine non è reale.

L'intera idea si basa sul fatto che gli stessi content creator siano interessati alla trasparenza e non a smascherare gli inganni, cosa che invece vuole fare Meta.

Se non funziona con le filigrane, come dovrebbe funzionare allora? Ciò che è già spesso stato provato è far riconoscere l'IA dall'IA stessa. Ma finora non ha mai funzionato.

I professori vorrebbero utilizzare l'IA per verificare se una tesi sia stata scritta con un'IA come ChatGPT. OpenAI, la società dietro ChatGPT, stava lavorando a un rilevatore di questo tipo, ma ha interrotto lo sviluppo nel 2022. La giustificazione è interessante: nessun rivelatore ha mai funzionato in modo affidabile. E, a quanto pare, Open AI non vede alcun segno di cambiamento nel prossimo futuro.

Questi rilevatori utilizzano gli stessi metodi dell'IA generativa. Entrambi si basano sul Machine Learning, ovvero sul riconoscimento di modelli basato su grandi volumi di testo come materiale di addestramento. I rilevatori determinano quanto un testo si discosti dallo stile di un'IA nota, come ChatGPT. Ma è solo un circolo vizioso, perché ChatGPT e simili imitano lo stile dell'essere umano e sono addestrati sulla base di testi scritti dall'essere umano.

Forse esiste uno stile tipico di ChatGPT. Tuttavia, questa è solo l'impostazione standard, che può anche essere modificata. Questi generatori, che si tratti di testo, immagini o musica, sono molto flessibili nello stile. Possono infatti imitare generi o addirittura individui.

Nel dettaglio, il caso delle immagini è leggermente diverso da quello dei testi, ma il problema di fondo è lo stesso. Un'IA che dovrebbe riconoscere in modo affidabile l'IA dovrebbe essere molto più avanzata o almeno funzionare in modo completamente diverso dallo strumento di IA che viene esaminato. Ed è proprio questo il problema: il riconoscimento e la generazione di modelli si basano sulla stessa tecnologia.

Finché non cambierà nulla di sostanziale, continueremo ad avere a che fare con fastidiosi contrassegni errati.

Il mio interesse per il mondo IT e lo scrivere mi hanno portato molto presto a lavorare nel giornalismo tecnologico (2000). Mi interessa come possiamo usare la tecnologia senza essere usati a nostra volta. Fuori dall'ufficio sono un musicista che combina un talento mediocre con un entusiamso eccessivo.

Curiosità dal mondo dei prodotti, uno sguardo dietro le quinte dei produttori e ritratti di persone interessanti.

Visualizza tutti